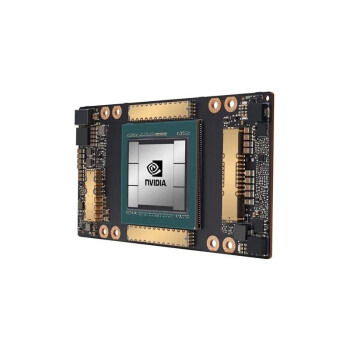

最近很多客户都在问,A100芯片到底好在哪儿?为啥这么多企业都盯着它不放呐?其实啊,这跟它的硬核参数脱不开关系。A100采用的是Ampere架构,拥有6912个CUDA核心,显存容量高达40GB,还有*

HBM2显存技术*的加持,带宽直接飙到了1.6TB/s。这样的配置,在大模型训练和推理场景下,表现确实亮眼。

说到实际性能,A100在MLPerf测试中的表现让人印象深刻。比如在BERT模型训练中,它的算力是上一代V100的1.5倍左右。而且呀,它的Tensor Core单元也是升级过的,FP16和INT8的混合精度计算效率提升了不少。对于企业来说,这个性能提升可太重要了,毕竟时间就是成本嘛。

价格方面,A100的报价大概是15万人民币左右。虽然看起来不便宜,但是是跟它的性能比起来,这性价比还是可以的。特别是对于那些需要大规模部署的企业,A100的稳定性和能效比都很能打。再加上它的NVLink技术,多卡互联的效率也很高,适合构建千卡级别的计算集群。

采购的时候啊,咱们还得注意几个关键点。首先是版本问题,A100有 PCIe 和SXM两种形态,SXM主要用在服务器里,性能更高一些。再有就是散热方案了,风冷和水冷得根据实际需求来选。另外啊,建议预留20%的安全库存,毕竟这玩意儿交货周期不短。

对于开发者来说,A100的兼容性也做得很到位。不管是PyTorch还是TensorFlow,都不用担心框架适配的问题。而且NVIDIA的CUDA生态也很完善,开发效率有保障。如果遇到报错,官方给的技术支持响应速度也很快,用起来还是比较省心的。

总的来说,A100芯片目前在AI训练领域确实是首选。它的性能、稳定性和生态都经受住了市场的考验。对于有GPU需求的企业来说,

Ampere架构和

HBM2显存这两大亮点,绝对值得重点关注。