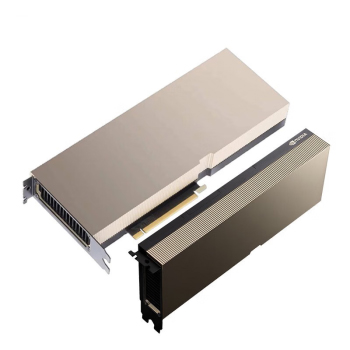

最近很多客户都在问英伟达A100 80G PCIe显卡的事儿。说实话,这款卡确实有它的独到之处。采用安培架构,80GB的HBM2显存带宽高达2TB/s,这种配置在大模型训练中简直是神器。

性能表现有多强?

从实际测试来看,A100在混合精度运算中的表现确实亮眼。特别是在BERT这类大模型训练上,比上一代V100快了近3倍。单个A100就能处理几十亿参数的模型,40张卡组成的集群那简直可以说是强悍了。

呐,说到集群部署,这里就得提一嘴NVLink技术。通过NVLink互联,多卡之间的数据交换效率能提升好几倍。对于需要处理大规模数据的场景来说,这个优势太重要了。

价格和成本怎么看?

现在市面上A100 80G PCIe单卡报价在15万左右,确实不便宜。但是是考虑到它的算力和应用场景,这个价格其实还行。毕竟比它更强的H100,整机价格可是要220万呢。

不过呀,企业采购时除了硬件成本,还得考虑电费和散热。A100的TDP是400W,40张卡就是16kW的功耗。按一度电0.8元算,光电费一年就得11万。

采购建议

对于需要大算力的企业来说,40张A100组集群确实是个不错的选择。特别是在AI训练、深度学习这些领域,它的性价比还是很高的。但是是如果是中小型企业,可能就得考虑一下成本问题了。

另外,现在市面上水货和翻新卡也不少。建议走正规渠道采购,虽然贵点,但是是质保有保障。毕竟这种高端显卡,万一买到假货就亏大了。

总的来说吧,英伟达A100 80G PCIe确实是目前市面上最顶尖的GPU之一。对于有大规模计算需求的客户来说,40张集群部署的方案值得考虑。