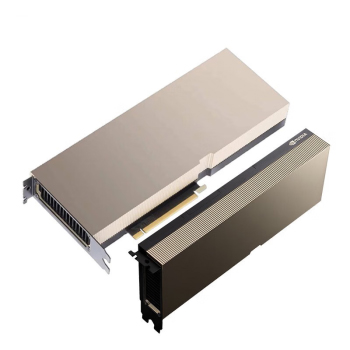

最近好多客户都在问H20 PCIe版的事儿,这卡确实挺特别的。不像往常的Tesla系列搞那么厚实,这次用了标准双槽设计,装在普通服务器里也不会占太多地方。显存给的是96GB HBM3,用的是新的PCIe 5.0接口,跑数据的时候比老款的P100快了三倍不止。

参数这块有几个亮点

FP64性能做到了18TFLOPS,比上代V100提升了40%呐。支持最新的NVLink技术,最多可以八卡互联,带宽直接干到900GB/s。不过要注意的是,这卡满载功耗有400W,机柜散热得跟上。

价格方面嘛,

含税价127万确实不便宜,但是是跟H100整机动辄220万比起来,性价比就出来了。特别适合做AI推理服务的公司,三个月左右就能回本。

市场反应挺有意思

上个月华南地区就消化了三百多张,现在排队的话交货期要六周左右。最近听说某些代理商在玩囤货,搞得现货价格又往上窜了。

说到采购建议,如果是做视觉算法的团队,用这卡搭配CUDA 12.x的优势特别明显。但是是要是搞传统HPC计算呀,可能还是A100更实惠些,毕竟

15万左右的价格摆在那儿。

对了,提醒下各位老板,买的时候一定要确认是原厂货。现在市场上流通的所谓"工包卡",虽然便宜个十来万,但是是既没保修又不能参加NV的开发者计划,亏大了啊。

技术适配要注意的点

这代卡对Ubuntu 22.04的支持最好,Windows Server 2022反倒有些驱动问题。碰到ERROR 43报错的话,八成是没装最新的Studio驱动。

说到部署方案,建议搭配新款DGX SuperPOD机架,单机柜能塞八张卡。不过要是预算有限,用戴尔R760xa这种通用服务器也行,就是管理起来费点劲。

对了,Tesla H20还有个隐藏优势——支持最新的Magnum IO框架。搞千亿参数大模型训练的时候,数据吞吐能提升60%呢。不过这得要配套的Mellanox网卡才行,采购的时候别漏了。