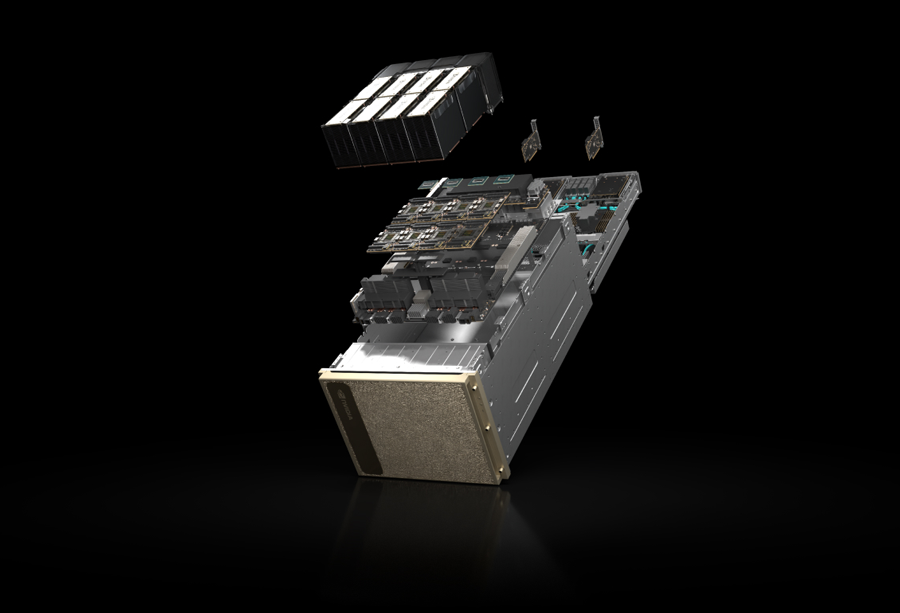

英伟达NVIDIA显卡H200

3月有现货 欢迎采购咨询

2023年8月30日,英伟达宣布了GH200 Grace Hopper,这款产品采用了HBM3e技术,为即将到来的H200 Tensor Core GPU奠定了基础。HBM3e的引入标志着英伟达在高速内存技术方面的又一次进步。

随后,在2024年6月3日,英伟达正式发布了H200 Tensor Core GPU。这款显卡基于GH200 Grace Hopper的技术,相对于H100,它在性能上实现了显著提升,内存容量增加了一倍,同时带宽也得到了大幅度的提高。H200不仅在计算能力上超越了前代产品H100,还在散热和多场景适应性方面进行了优化,使其成为当时市场上最强大的AI芯片之一。

英伟达的H200 Tensor Core GPU在2024年全球超算大会上引起了广泛关注,被认为是该公司在高性能计算领域的又一里程碑。凭借其卓越的性能和创新的技术,H200展现出了在未来市场中极大的发展潜力,尤其是在人工智能、深度学习以及科学计算等领域的应用前景。

英伟达H200是基于Hopper架构的AI GPU芯片,它代表了当前高性能计算和人工智能领域的尖端技术。英伟达H200是一款针对AI和高性能计算需求设计的高端GPU芯片,它在内存容量、带宽以及制程技术上都有显著的提升。

英伟达h200参数介绍

1、制程技术:H200采用了先进的台积电4nm制程工艺。

2、核心架构:该芯片依旧沿用了Hopper架构,这是英伟达为AI和高性能计算设计的专用架构。

3、HBM3e显存:H200首次搭载了HBM3e显存,这种新一代的显存技术在速度和容量上都有显著提升。

4、内存容量:H200的内存容量达到了141GB,相比前代产品H100的80GB容量,实现了翻倍的提升。

5、带宽性能:得益于HBM3e显存,H200的显存带宽高达4. 8TB /s,比H100的3.35TB/s提升了约43%。

训练能力

在之前用于评估 AI 芯片性能的一个重要指标——训练能力方面,H200 并没有明显的提升。根据英伟达提供的数据,对于 GPT-3 175B 大模型的训练任务而言,H200 只比 H100 强 10%。

H200 和 H100 芯片都基于英伟达的 Hopper 架构开发,因此这两款芯片是相互兼容的。对于已经使用 H100 的企业来说,无需进行任何调整,可以直接进行更换。此外,就峰值算力而言,H100 和 H200 实际上是相同的,它们的 FP64 矢量计算能力为 33.5TFlops,FP64 张量计算能力为 66.9TFlops,提升的参数主要是显存容量和内存带宽。

¥暂无定价 咨询道通

实物商品

H200 和 H100 芯片都基于英伟达的 Hopper 架构开发,因此这两款芯片是相互兼容的。对于已经使用 H100 的企业来说,无需进行任何调整,可以直接进行更换。此外,就峰值算力而言,H100 和 H200 实际上是相同的,它们的 FP64 矢量计算能力为 33.5TFlops,FP64 张量计算能力为 66.9TFlops,提升的参数主要是显存容量和内存带宽。